ربات های وب (که به نام های سرگردانان وب، خزندگان یا عنکبوت ها نیز شناخته می شوند) به برنامه هایی می گویند که به صورت خودکار سراسر وب را می گردند و جستجو می کنند. موتورهای جستجویی نظیر گوگل از آنها برای محتوای درون وب استفاده می کنند و اسپمرها برای به دست آوردن ایمیل آدرس ها. آنها کارایی های بی شماری دارد.

توضیحات واضح در مورد فایل robots.txt

دارندگان سایت ها از robots.txt جهت معرفی ساختار سایتشان به ربات های سراسر وب استفاده می کنند.

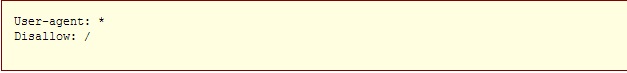

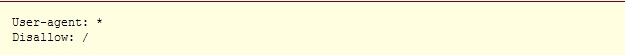

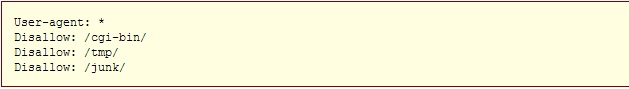

یک مثال در ارتباط با چگونگی کارکرد این فایل: یک ربات جستجوگر مثل ربات گوگل قصد ورود به سایت شما را دارد تا موارد مورد نظرش چون خطاها، صفحات، محتوا، تصاویر و غیره را ایندکس کند. در صورتی که صفحه ورودی شما http://www.example.com/welcome.html باشد، ربات مورد نظر ابتدا و پیش از هر نوع بررسی سایت شما نشانی http://www.example.com/robots.txt را چک خواهد کرد. و در نهایت به این دستورات بر خواهد خورد:

عبارت User-agent: * به معنای این است که این سایت و این دستور برای هم? ربات ها یکسان است. و قسمت Disallow: / حاوی این پیام است که هیچ رباتی نباید هیچ قسمتی از این سایت را بررسی و مشاهده نماید.

دو نوع نگرش نسبت به استفاده کنندگان از robots.txt وجود دارد:

1. ربات ها می توانند robots.txt شما را نادیده بگیرند! به خصوص آنکه ربات های مخرب، کارشان اسکن نمودن سراسر وب برای یافتن نقص های امنیتی، ایمیل آدرس ها و غیره است، کوچکترین توجهی به محتویات robots.txt ندارند.

2. فایل robots.txt یک فایل در دسترس عموم می باشد. هرکسی می تواند ببیند که شما کدام قسمت را تمایل ندارید که ربات های دیگر ببینند.

*پس برای مخفی نمودن اطلاعاتتان با استفاده از robots.txt تلاش نکنید.

نحو? ساخت یک فایل robots.txt

کجا آن را قرار دهیم؟

پاسخ کوتاه: در بالاترین سطح دایرکتوری سرور سایتتان

پاسخ کامل: زمانیکه یک روبات به دنبال فایل robots.txt برای نشانی URL شما می گردد، به دنبال اولین اسلش پس از اکستنشن شما می رود و به صورت اتوماتیک عبارت robots.txt را قرار می دهد.

برای مثال اگر داشته باشیم: http://www.example.com/shop/index.html، ربات مورد نظر /shop/index.html را حذف نموده و /robots.txt را جایگزین و در انتهای URL قرار می دهد.

به همین خاطر شما به عنوان دارنده سایت می بایست این فایل را در مکان صحیح و جایی قرار دهید که در نتایج جستجو دیده شده و عمل نماید. معمولا این فایل را در جایی مشابه همان صفحه اصلی سایت (index.html) یا همان صفح? به اصطلاح خوشامدگویی قرار می دهند.

*فراموش نکنید که تمام حروف این فایل کوچک نوشته می شوند: صحیح: robots.txt ؛ غلط: Robots.TXT

چه چیزی در آن بنویسیم؟

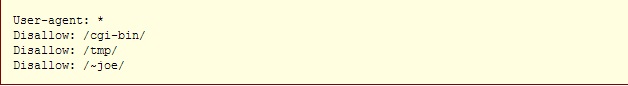

فایل robots.txt یک فایل متنی است که از یک یا تعداد بیشتری از دستورات ساخته شده است. به صورت معمول شامل یک دستور شبیه به این می شود:

در مثال فوق شاهد 3 دایرکتوری محروم شده هستید که با استفاده از این 3 دستور، پیامی به ربات های سراسر وب ارسال می کند که به معنی عدم دسترسی ایشان به فایل های مشخص شده است.

توجه داشته باشید که برای محروم نمودن ربات ها به یک URL خاص، باید در هر خط مجزا یک دستور جدید را وارد نمایید. شما نمی توانید دستور Disallow: /cgi-bin/ /tmp/ را در یک خط وارد نمایید. همچنین نباید در مقابل یک دستور، خط را خالی بگذارید چراکه برای ربات این تصور می شود که دستور مورد نظر برای تمام وبسایت شما قابل اجرا است.

ضمنا شما نمی توانید به صورت منظم و نامنظم دستورات داخل فایل را با یکدیگر ادغام نمایید. برای مثال علامت "*" در فیلد User-agent به معنای آن است که دستورات وارد شده در مقابل این عبارت برای تمامی ربات ها لازم الاجراست. به طور مشخص و عینی شما نمی توانید دستوراتی چون User-agent: *bot*", "Disallow: /tmp/*" or "Disallow: *.gif را در کنار همدیگر وارد نمایید.

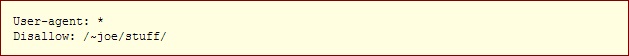

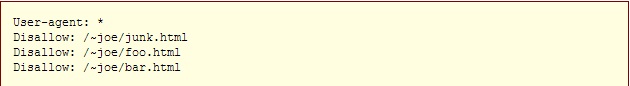

بررسی دقیق نمایید که چه چیزهایی را نمی خواهید ربات ها ببینند. هرچیزی را که نمی خواهید آنها ببینند را به راحتی می توانید از دیدشان مخفی کنید. به مثال های زیر توجه بفرمایید:

خط فرمان به تمام ربات ها برای عدم دسترسی به کل سایت شما

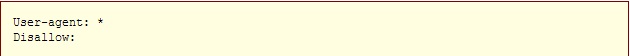

خط فرمان به تمام ربات ها برای دسترسی به کل سایت شما

برای اجرای دستور فوق همچنین می توانید یک فایل robots.txt بدون متن بسازید و هیچوقت به سراغش نروید.

خط فرمان به تمام ربات ها برای عدم دسترسی به بخشی از سایت شما

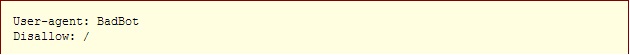

خط فرمان به یک ربات خاص برای عدم دسترسی اش به کل سایت (برای مثال نام ربات "BadBot" است)

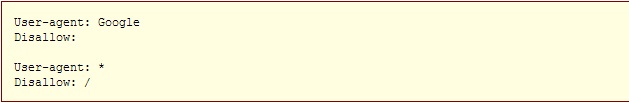

خط فرمان به تنها یک ربات خاص جهت دسترسی به کل سایت شما و عدم دسترسی سایر ربات ها:

خط فرمان به تمام ربات ها برای عدم دسترسی به تمام فایل ها به جز برخی از آنها:

یا برای مشخص نمودن دقیق یک نشانی و یا فایل می توانید از این دستورات استفاده کنید و نشانی دقیق را در باکس robots.txt وارد نمایید.

تصور می کنیم که شما 2 سایت طراحی کرده اید و هرکدام در دو زمین? متفاوت و مختص به خود مشغول به فعالیت هستند. یکی از این سایتها را 2 سال پیش طراحی نموده اید و در جریان این 2 سال فعال بوده است. و دیگری را حدود 1 ماه است که اجرا نموده و هر روز مطالبی تخصصی در آن درج می کنید.

هیچ کدام از این 2 سایت سئو نشده اند. حال قصد دارید سایت شمار? 3 را در یکی از همان دو زمین? تخصصی راه اندازی کنید.

اکنون این پرسش مطرح می شود: آیا باید سایت قدیمی را بهینه سازی و سئو کنید و یا از نو سایتی دیگر طراحی کنید و از همان ابتدا آن را سئو، بهینه سازی و اصولی نمایید؟

این پرسش مدت هاست در ذهن مدیران وبسایت هاست. ما در مثال بالا بهترین حالت ممکن را آوردیم. حالتی که سایت پیشین هم فعال بوده و تنها سئوی خاصی بر روی آن انجام نگرفته است. اکنون فرض کنید که سایت قدیمی با قدمت 2 ساله نه تنها سئوی مناسبی نداشته که محتوای تکراری و کپی درج نموده، دور? زمانی مشخصی برای به روزرسانی انجام نداده، و همچنین از ابزار وبمستر تولز نیز کوچکترین بهره ای نبرده تا آنالیزی هرچند کلی از تارنمای مربوطه داشته باشد.

در ارتباط با مدل شمار? 1، پاسخ مورد نظر متفاوت با مدل شمار? 2 می باشد. از همین مثال دوم آغاز می کنیم:

پاسخ کوتاه این است که سئوی تارنمای مذکور با توجه به عدم استفاد? وبمستر آن از ابزار وبمستر تولز گوگل، اگر ناممکن نباشد به شدت غیر قابل پذیرش است که بتواند توجه ربات ها و صفحات نتایج جستجوی گوگل را به خود معطوف کند (آن هم با این ارفاق که از کنار لینک های جریمه شده بگذریم!).

اما نشدنی هم نیست. این نشدنی نبودن به راحتی طراحی یک سایت جدید نیست و بسیار سخت خواهد بود. از موارد ساده ای که می توان به آن اشاره کرد، ثبت سایت در موتورهای جستجو، ثبت در وبمستر تولز گوگل و آنالیز کامل آن پس از حدود 1 ماه، تولید محتوای جدید، رفع خطاهای واکنش دستی و غیره! برای مشاوره و راهنمایی با کارشناسان ما تماس بگیرید!

و اما مورد یکم که مرتبط با سایتی است که 2 سال فعالیت مداوم داشته، تولید محتوا نموده اما بر اساس اصول سئو حرکت نکرده است هرچند که اولین اصل سئو تولید محتوای جدید و غیر تکراری است.

چنین سایتی با صرف زمان قابل توجهی به آسانی و البته با استفاده از متخصصین مجرب، امکان ارتقای پلکانی و حتا آنی را داشته و در جایگاه حقیقی خود در صفحات نتایج جستجوی گوگل قرار خواهد گرفت. خواه رتب? یکم و خواه رتبه دهم!

از روش های موثر و آغازین سئوی یک سایت، ثبت آن در وبمستر گوگل، ارسال ربات های گوگل یا Crawlerها جهت بررسی تک تک لینک های تارنمای مورد نظر، کشف و اصلاح خطاهای سرور اعم از 404، 503 و امثالهم، یافتن Manual Actionها، ساختن بک لینک داخلی و ارسال و دریافت بک لینک حقیقی خارجی و مواردی از این دست می باشند.

توجه داشته باشید که سئو تنها محدود و منحصر به ایجاد چند لینک داخلی، یافتن و حذف و اصلاح نمودن لینک های تخریب شده و غیر قابل استفاده نیست. سئو شدن یک وبسایت نیازمند فردی متخصص در همین زمینه می باشد که به جای اصلاح، سایت را به اعماق جریمه ها و نابودی کامل آن نکشاند. بارها در سایر مقالات و کتب سئوی زیاد و عدم سپردن بهینه سازی سایت به دست افراد نابلد، طرح شده است. همانطور که برای هر آچاری که بر ماشین تان می کشید ارزش قائلید و نگران هستید، همان را به سطح سایت خود ارتقا داده و جلوی تخریب آن را نه تنها گرفته که به بهترین وجه ممکن کار رو تمام خواهیم نمود.

توجه بفرمایید که در بسیاری از سرویس های وب نویسی، عدم ایجاد تغییرات در برخی از این سرویس ها به صورت هشدارگونه در ارتباط با فایلهایی چون robots.txt مطرح گشته است. در ارتباط با robots.txt بیشتر بخوانید.

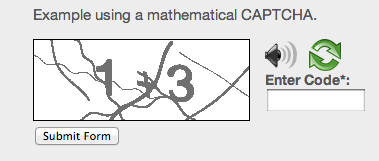

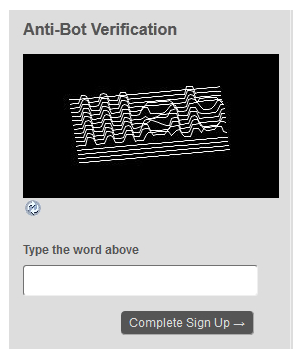

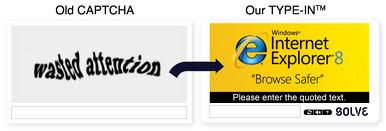

حتما تا بحال هنگام فعالیت های اینترنتی مانند تبادلات مالی آنلاین ، ترافیک وب سایت ها و موتورهای جستجو ، نظرسنجی های آنلاین ، ثبت نام های آنلاین ، سرویس های ایمیل رایگان و بسیاری دیگر از چنین موارد با کادری روبرو شده اید که حاوی اعداد و یا حروف به صورت نامرتب و کج است Captcha نرم افزاری ست که با پرسیدن سوالاتی که جواب دادن به آنها توسط انسان راحت است می پردازد و به منظور حمله به این سیستم ها طراحی شده اند.Captcha در واقع یک مکانیزم امنیتی محسوب می شود که تعیین می کند که طرف مقابل شما یک کامپیوتر است یا یک انسان .لازم به ذکر است بدانیم که تست تورینگ توسط انسان برگزار می شود و هدفش تشخیص ماشین است اما کپچا توسط ماشین برگزار می شود و هدفش تضخیص انسان است.

پنج نوع از کپچاهای مرسوم عبارتند از:

√ Captcha تصویری همراه با صدای تلفظ شده کاراکتر درون عکس

√ Captcha ای که باید عکس موردنظر را در تصویر پیدا کرد

√ Captcha ای که باید که مسدله ی ریاضی ساده حل کرد

√ Captcha های سه بعدی

√ Captcha هایی با استفاده از تبلیغات

با استفاده از کپچا تنها انسان ها قادر به انتشار نظر در بخش وبلاگ سایت شما خواهند بود و به این ترتیب نیاز به عضویت در سایت یا وبلاگ شما برای جلوگیری از نظرات اسپم نیست.

سایت هایی مثل گوگل و یاهو که نیازمند عضویت تعداد بسیاری از افراد هستند قبل از بکارگیری کپچا مشکلات زیادی نظیر ساخت تعداد زیادی از اکانت دارند که بتوانند در چند دقیقه صدها ایمیل بسازند اما پس از استفاده از سیستم کپچا تنها انسان ها قادر به تکمیل فرم و ثبت نام نهایی می باشند و امروزه به یک ضرورت در سیستم های رایگان تبدیل شده است.

از کاربردهای دیگر کپچا می توان به جلوگیری از هک شدن اشاره کرد به طوریکه با چند تلاش اشتباه در سیستم های ایمیل مانند یاهو یک کپچا به کاربر نشان داده میشود تا از این روش هک جلوگیری شود.

نکته ی مهم : استفاده از کپچاهایی که تشخیص آن حتی برای انسان هم مشکل است موجب ترک کاربران می شود همچنین بکارگیری روش های دیگری مانند شناسایی نظرات اسپم و ذخیره در حافظه سرور میتوانند جایگزین مناسبی برای کپچا در سایت های کم بازدید باشند.

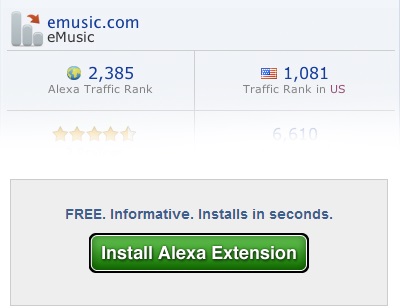

در تعریفی کلی، در دنیای اینترنت، الکسا را اینطور معرفی کرده اند:

شرکت الکسا اینترنت، واقع در کالیفرنیا و از شرکت های زیر مجموع? شرکت عظیم آمازون میباشد که وظیفه اش ارائ? سرویسی تحت عنوان اطلاعات ترافیک وب عنوان شده است.

ما در این جستار، به بررسی قسمت هایی از الکسا به خصوص تولبار الکسا میپردازیم.

نحو? امتیاز دهی و یا رنکینگ سایت الکسا، بر مبنای یک تولبار ساده است که کاربران مرورگرهای اینترنت اکسپلورر، فایرفاکس و گوگل کروم می توانند آن را نصب و امکانات آن استفاده کنند. امکاناتی که تولبار الکسا به استفاده کنندگانش میدهد، به طور کلی در 4 دسته بندی قرار میگیرند:

√ اعتبار ترافیک الکسا: می توانید ببینید که یک وبسایت چقدر معروف و مورد توجه است.

√ پیوندهای مربوطه: نزدیک ترین وبسایتی که مربوط به آنچه که در حال دیدن هستید را به شما معرفی میکند.

√ راه بازگشت: می توانید چگونگی یک وبسایت را در گذشته ببینید.

√ تحلیل جستجو: امکان این را دارید که ببینید چه عباراتی، در نتایج جستجوها به سایت شما ترافیک میفرستند.

کاربران و به خصوص وبمسترانی که این تولبار را بر روی مرورگر خود نصب کنند، از این 4 دسته و سایر امکانات خوب الکسا به رایگان بهره خواهند برد.

اصولا بسیاری از کاربران از نصب هرگونه تولباری بر روی مرورگرهایشان خودداری میکنند. چراکه تولبارهای بسیار زیادی تنها برای تبلیغات بر روی مرورگرها نصب میشوند، بسیار آزاردهنده و گاها مخرب هستند. حتا همین تولبار الکسا با اعتباری که کسب نموده تا سال 2005 تنها 10 میلیون بار دانلود شده است. همچنین این تولبار توسط سپر مدافع شرکت مایکروسافت برای اینترنت اکسپلورر نسخ? 7، به عنوان مالور، نشانه گذاری شد.

با هم? این اوصاف، تولبار الکسا در حیط? کاری خود به عنوان خالق امتیاز دهی و شماره بندی وبسایت های دنیا بر اساس دسته بندی گوناگون شناخته و به خوبی استفاده می گردد. تولباری که در کمک کردن به سئو، موتورهای جستجو و بهینه سازی وبسایت ها نقشی اساسی ایفا کرده و همچنان به این نقش به صورت پررنگ و بی رقیب ادامه می دهد.

دلایل زیادی وجود دارد که دسترسی ربات گوگل به صفحات و یا کل یک سایت محدود و یا کاملا قطع شده باشد. یکی از این دلایل می تواند تنظیمات DNS دامین یا ایجاد مشکلاتی در سرور سایت باشد. این قبیل اتفاقات میتواند به Seoی سایت شما آسیب بزند و در موارد بسیاری، موتور جستجوگر و ربات گوگل نتواند صفحات سایت را ایندکس کند.